-이보다 더 감동적일 순 없다

[데일리비즈온 김소윤 기자] 환자를 도와주는 로봇 기술로 인해 불의의 사고로 신체를 가눌 수 없는 이들이 기적을 경험하고 있다. 내 팔처럼 움직이는 로봇손이 있는가 하면 뇌에 의해 성공적으로 조절되는 로봇팔도 있다. 세상 어디에도 없는 로봇의 특급 활약상을 살펴봤다.

◇ 불치병 극복한 가수...‘로봇손’ 상용화 단계

지난달 한 방송프로그램 출연 중 교통사고로 사지 마비 장애를 앓게 된 가수가 등장해 화제였다. 주인공은 더 크로스 맴버 김혁건 씨. 그는 사고 이후 복식 호흡을 하지 못해 가수의 길을 포기할 뻔했지만 로봇 덕분에 다시 특유의 고음을 낼 수 있게 됐다. 이 기술은 서울대학교 로봇융합기술원 방영봉 교수팀이 개발했다. 방 교수팀은 배를 아래에서 위로 45도 각도로 밀어 올려줘 가슴과 배를 나누는 가로막 근육인 횡격막을 올려 폐부에 숨을 입 밖으로 강하게 배출할 수 있도록 도와주는 로봇장치를 개발했다.

5년 전 이들에 의해 처음 개발된 이 로봇은 여러 종류의 기계로 나와 있고 계속 개발 중이다. 김 씨는 “처음엔 타인이 기계를 조작해 호흡을 맞추기 어려웠지만 이후 조이스틱으로 조절할 수 있는 로봇장치를 통해 혼자서도 노랠 부를 수 있게 됐다”면서 “최근 방송에서 사용한 로봇장치는 윗배, 아랫배, 옆구리를 전부 아래에서 위로 올려주어 횡격막을 조금 더 많이 이용할 수 있었다”고 설명했다.

환자를 도와주는 로봇의 개발 사례가 이번이 처음은 아니다. 이미 4년 전, 뇌의 전기신호와 눈동자의 움직임을 포착해 서명하거나 포크를 사용하는 등의 일상활동을 자연스럽게 수행하는 ‘로봇손’이 독일에서 개발된 바 있다. 당시 튀빙겐대학병원 수르조 소카다 박사 연구팀에 의해 개발된 로봇은 신체에 전극을 이식할 필요가 없고 특수장치가 장착된 모자를 쓰고 사용하는 방식이라 실용성이 컸다.

‘로봇손’ 사용자가 특수 센서가 장착된 모자를 쓰면, 뇌의 전기신호와 눈동자의 움직임이 측정돼 태블릿 PC로 전송되는 원리다. 사용자는 PC의 명령을 받은 장갑 형태의 기계를 이용해 원하는 대로 세밀한 동작을 수행할 수 있다.

실제로 척수장애를 앓아온 테스트 참가자들이 개발된 로봇팔을 이용해 감자 칩을 집어 먹거나 문서에 서명하는 등의 활동을 하는 데 어려움이 없었다. 특히 작동법을 익히는 데 10분도 걸리지 않아 사용자들의 만족도가 높았다. 다만 당시 개발된 로봇은 사용자가 어깨와 팔을 어느 정도 움직일 수 있어야 했다. 이에 심각한 중증 사지 마비 환자는 사용이 어렵다는 단점이 있었다.

◇ 손보다 눈이 더 빠른 지능형 웨어러블 기술

최근엔 사지가 마비된 환자가 로봇을 이용해 걷는 단계까지 기술이 발전했다. 지난해 프랑스에서는 사지마비가 된 20대 청년이 웨어러블 로봇을 통해 다시 걸을 수 있게 됐다. 5년 전 낙상 사고로 척수가 다친 티보 씨는 뇌의 신호에 따라 움직이는 외골격 로봇 ‘엑소 스켈레톤’을 입고 한 걸음 한 걸음 발을 떼는 모습을 보였다.

이 로봇은 뇌와 두피 사이에 삽입 된 64개 전극이 달린 2개의 측정장치가 매개체가 돼 감각과 운동 피질 영역에서 뇌의 신호를 모아 로봇에 전달하는 원리다. 티보 씨가 몸 전체를 움직이기까지 뇌 신호를 보내 물건을 집는 가상훈련 등 2년이란 시간이 필요했다고 연구팀은 설명했다.

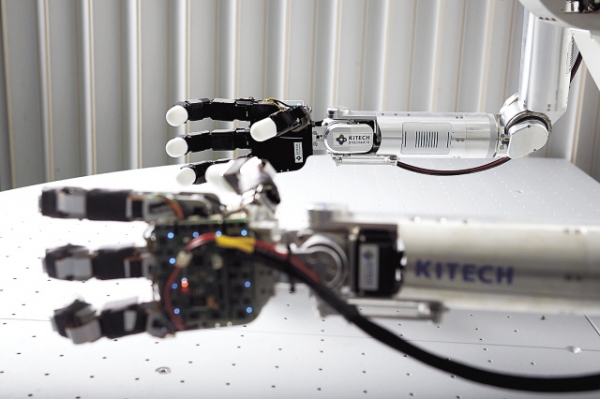

이 뿐만이 아니다. 국내 연구진은 뇌파를 측정할 필요 없이 영상으로 사람의 움직임만 보고 의도를 파악해 스스로 작동하는 지능형 웨어러블 로봇 시스템을 세계 최초로 개발했다. 예를 들어 컵을 집어 드는 행위를 자연스럽게 구사할 수 있게 된 것이다.

지난해 인간중심소프트로봇기술연구센터(SRRC)의 조규진 센터장(서울대 기계항공공학부 교수)과 조성호 브레인그룹장(KAIST 전산학부 교수) 연구팀은 영상으로 사람의 의도를 예측하고 웨어러블 로봇이 스스로 그 의도에 맞는 연속 동작을 수행하도록 하는 AI ‘비디오넷(VIDEO-Net)’을 개발했다. 이 내용은 국제학술지 ‘사이언스 로보틱스’ 지난해 1월 30일 자에 발표됐다. 웨어러블 로봇에 딥러닝(심층기계학습) 기반 영상 분석 기술을 접목했다.

‘손보다 눈이 더 빠르다(Eyes are faster than hands)’라는 연구 제목으로 주목을 받은 연구팀은 “앞으로 신체 마비 환자뿐만 아니라 거동이 불편한 노인을 보조하는 용도로도 로봇을 개발할 것”이라고 밝혔다.